Фреймворки для глубокого обучения, такие как TensorFlow и PyTorch, играют важную роль в разработке и применении нейронных сетей. Они предоставляют инструменты для построения, обучения и развертывания моделей, что значительно упрощает работу с нейронными сетями и позволяет ускорить процесс разработки. В этом материале мы рассмотрим основные возможности и особенности этих фреймворков, их основные компоненты, а также реальные примеры их использования.

TensorFlow

TensorFlow — это один из самых популярных фреймворков для глубокого обучения, разработанный компанией Google. TensorFlow предоставляет как низкоуровневый, так и высокоуровневый API для создания и обучения моделей глубокого обучения. В его основе лежит граф вычислений (computation graph), который позволяет эффективно распределять вычисления на CPU, GPU и TPU.

Основные компоненты TensorFlow

Keras API:

Высокоуровневый интерфейс для создания моделей, который стал стандартом для TensorFlow. Keras предоставляет простой синтаксис для создания и обучения моделей, что делает TensorFlow доступным даже для начинающих.

TensorBoard:

Инструмент для визуализации процесса обучения, который позволяет отслеживать метрики (потери, точность), графики модели, гистограммы весов и другие параметры в реальном времени.

Граф вычислений (computation graph):

TensorFlow строит граф вычислений, который позволяет выполнять параллельные операции и эффективно использовать ресурсы, такие как GPU и TPU. Это также позволяет компилировать и оптимизировать вычисления.

TensorFlow Lite и TensorFlow Serving:

TensorFlow Lite — это облегчённая версия TensorFlow для мобильных и встроенных устройств. TensorFlow Serving позволяет развертывать обученные модели в продакшене.

Пример использования TensorFlow

Пример создания и обучения простой нейронной сети для классификации изображений на наборе данных MNIST:

import tensorflow as tf

from tensorflow.keras import layers, models

# Загрузка данных MNIST

(X_train, y_train), (X_test, y_test) = tf.keras.datasets.mnist.load_data()

# Нормализация данных

X_train = X_train / 255.0

X_test = X_test / 255.0

# Построение модели

model = models.Sequential([

layers.Flatten(input_shape=(28, 28)), # Преобразование изображений в вектор

layers.Dense(128, activation='relu'), # Полносвязный слой

layers.Dropout(0.2), # Dropout для регуляризации

layers.Dense(10, activation='softmax') # Выходной слой для классификации

])

# Компиляция модели

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# Обучение модели

model.fit(X_train, y_train, epochs=5)

# Оценка модели

loss, accuracy = model.evaluate(X_test, y_test)

print(f"Точность на тестовых данных: {accuracy:.4f}")

Использование TensorFlow для работы с GPU

TensorFlow автоматически использует доступные GPU для ускорения обучения. Для этого вам нужно иметь установленный драйвер CUDA и библиотеку cuDNN. TensorFlow автоматически определит наличие GPU и начнет использовать его для ускорения вычислений.

Пример того, как можно проверить наличие GPU:

import tensorflow as tf

# Проверка наличия GPU

print("Доступные устройства:", tf.config.list_physical_devices('GPU'))

TensorBoard: Визуализация обучения

TensorBoard — это инструмент для отслеживания метрик и визуализации процесса обучения. Он позволяет мониторить такие параметры, как точность и ошибка модели, а также визуализировать структуру модели и гистограммы весов.

Пример использования TensorBoard:

import tensorflow as tf # Настройка коллбека для TensorBoard tensorboard_callback = tf.keras.callbacks.TensorBoard(log_dir='./logs') # Обучение модели с использованием TensorBoard model.fit(X_train, y_train, epochs=5, callbacks=[tensorboard_callback])

Для запуска TensorBoard выполните команду в терминале:

tensorboard --logdir=./logs

PyTorch

PyTorch — это фреймворк для глубокого обучения, разработанный Facebook. PyTorch получил популярность благодаря своей простоте и гибкости, особенно среди исследователей и академического сообщества. Одной из ключевых особенностей PyTorch является динамический граф вычислений, который позволяет изменять структуру сети во время выполнения программы, что делает его удобным для отладки и экспериментов.

Основные компоненты PyTorch

Autograd:

Механизм автоматического дифференцирования в PyTorch, который вычисляет градиенты для всех операций, выполненных с тензорами. Это делает процесс обратного распространения ошибки простым и прозрачным.

Torch.nn:

Модуль для создания нейронных сетей. В нем содержатся все основные слои и функции активации, которые нужны для построения моделей, включая сверточные и рекуррентные слои.

DataLoader:

Удобный инструмент для загрузки и пакетной обработки данных, поддерживающий многопоточность. Это делает работу с большими наборами данных более эффективной.

GPU поддержка:

PyTorch автоматически поддерживает обучение на GPU и позволяет переносить тензоры и модели на GPU для ускорения вычислений.

Пример использования PyTorch

Пример создания и обучения простой нейронной сети на PyTorch для классификации изображений MNIST:

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

# Подготовка данных

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))])

train_data = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_data = datasets.MNIST(root='./data', train=False, download=True, transform=transform)

train_loader = torch.utils.data.DataLoader(train_data, batch_size=64, shuffle=True)

test_loader = torch.utils.data.DataLoader(test_data, batch_size=64, shuffle=False)

# Построение модели

class SimpleNN(nn.Module):

def __init__(self):

super(SimpleNN, self).__init__()

self.fc1 = nn.Linear(28*28, 128)

self.fc2 = nn.Linear(128, 64)

self.fc3 = nn.Linear(64, 10)

def forward(self, x):

x = x.view(-1, 28*28) # Преобразование изображений в вектор

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

x = self.fc3(x)

return torch.log_softmax(x, dim=1)

model = SimpleNN()

# Оптимизатор и функция потерь

optimizer = optim.Adam(model.parameters(), lr=0.001)

criterion = nn.NLLLoss()

# Обучение модели

def train_model(model, train_loader, criterion, optimizer):

model.train()

for epoch in range(5):

running_loss = 0

for images, labels in train_loader:

optimizer.zero_grad()

output = model(images)

loss = criterion(output, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

print(f"Эпоха {epoch+1}, Потери: {running_loss / len(train_loader)}")

train_model(model, train_loader, criterion, optimizer)

# Оценка модели

def evaluate_model(model, test_loader):

model.eval()

correct = 0

total = 0

with torch.no_grad():

for images, labels in test_loader:

output = model(images)

_, predicted = torch.max(output, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f"Точность на тестовых данных: {100 * correct / total:.2f}%")

evaluate_model(model, test_loader)

Использование PyTorch с GPU

PyTorch позволяет легко переносить модели и тензоры на GPU для ускорения вычислений. Для этого достаточно использовать метод to(device), где device — это ваш GPU.

Пример переноса модели и данных на GPU:

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model.to(device)

# Перенос данных на GPU

images, labels = images.to(device), labels.to(device)

Автоматическое дифференцирование в PyTorch

PyTorch поддерживает автоматическое дифференцирование с помощью autograd, что упрощает процесс обратного распространения ошибки. Градиенты вычисляются автоматически, что позволяет легко обучать модели.

Пример использования autograd:

import torch # Пример тензора с включенным отслеживанием градиентов x = torch.tensor([2.0], requires_grad=True) # Вычисление функции y = x ** 2 # Вычисление градиента y.backward() # Градиент x print(x.grad) # Печатает градиент: 4.0

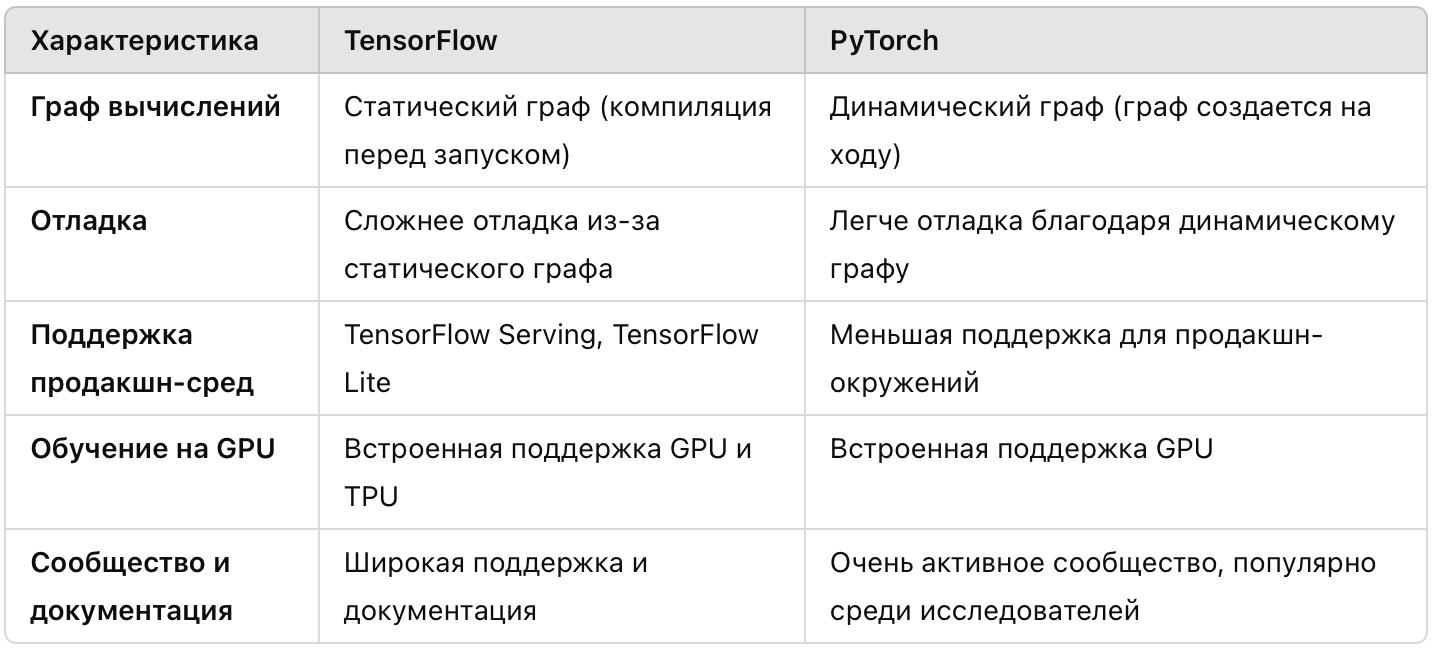

Сравнение TensorFlow и PyTorch

Реальные примеры использования TensorFlow и PyTorch

TensorFlow в продакшн-средах

TensorFlow активно используется для развёртывания моделей в продакшн-средах благодаря инструментам, таким как TensorFlow Serving, который позволяет легко интегрировать обученные модели в веб-приложения или мобильные устройства. TensorFlow также поддерживает TensorFlow Lite для мобильных и встроенных устройств, что делает его идеальным выбором для развёртывания в приложениях реального времени.

Пример использования TensorFlow Lite для мобильных устройств — это использование обученных моделей для распознавания объектов на мобильных камерах или анализа текстовых данных на устройствах с ограниченными ресурсами.

PyTorch в исследованиях

PyTorch стал стандартом для исследований в области глубокого обучения благодаря своей гибкости и простоте отладки. Динамический граф вычислений позволяет исследователям быстро экспериментировать с архитектурами нейронных сетей, что делает его предпочтительным выбором в академических кругах и для разработчиков новых архитектур.

Пример применения PyTorch в исследованиях — создание и обучение сложных моделей, таких как трансформеры, используемые в задачах обработки естественного языка, включая модели типа GPT.

Заключение

Оба фреймворка, TensorFlow и PyTorch, предоставляют мощные инструменты для работы с нейронными сетями. TensorFlow идеально подходит для развёртывания моделей в промышленной среде и имеет отличные инструменты для визуализации и мониторинга, такие как TensorBoard. PyTorch, в свою очередь, предоставляет гибкость и удобство для исследований, что делает его отличным выбором для прототипирования и отладки.

Рекомендации для самостоятельного изучения:

- Книга «Deep Learning with Python» от François Chollet.

- Официальная документация TensorFlow и PyTorch.

- Курсы по глубокому обучению на Coursera, включая курс от DeepLearning.ai.

Добавить комментарий